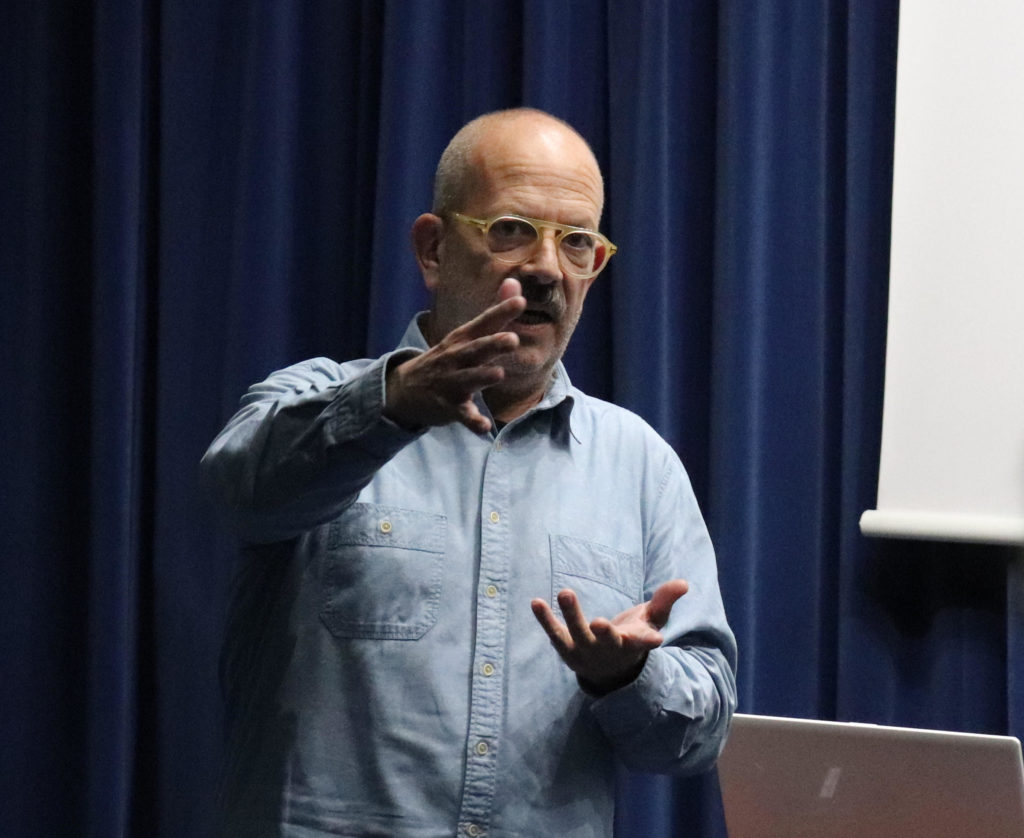

Josep Puyol-Gruart es investigador titular del Instituto de Investigación en Inteligencia Artificial dentro del Centro Superior de Investigaciones Científicas (IIIA-CSIC) y presidente de la Asociación Catalana para la Inteligencia Artificial (ACIA). Este experto repasa el camino de la Inteligencia Artificial (IA) hasta su actual Edad de Oro, avisa sobre algunas exageraciones y ahonda en su desarrollo y en los retos que plantea su uso en el día a día.

La definición más general de la Inteligencia Artificial es que trata de reproducir artificialmente los comportamientos que consideramos inteligentes, como percibir, razonar, aprender, tomar decisiones o resolver problemas. Su evolución en los últimos años ha hecho que la IA esté cada vez más presente en nuestro día a día. Cuando sacamos una foto con nuestro móvil, estabiliza la imagen y reconoce nuestras caras o mejora la calidad de la toma. Cuando navegamos en una red social, nos recomienda noticias en función de nuestra ideología, nos sugiere contactos o nos muestra publicidad relacionada con nuestros intereses. La IA controla los movimientos y la intensidad de limpieza de algunos robots aspiradores. Es capaz de entender nuestra voz y responder cuando preguntamos a un asistente digital. También la encontramos en los sistemas informáticos de nuestro banco o de nuestra aseguradora analizando nuestro perfil de riesgo, cuánto dinero puede prestarnos o qué productos financieros son más adecuados.

Están ustedes en las portadas, debe de ser bonito

Es agradable que ahora se preste tanta atención a la Inteligencia Artificial, pero si observamos su historia ya ha pasado antes por lo que llamamos los inviernos de la IA. Es fácil emocionarse demasiado y crear unas expectativas que no podremos cumplir. Esto es lo que llevó en el pasado a estos inviernos y algunos piensan que ya nos acercamos al siguiente.

Usted se unió al grupo de IA del Centro de Estudios Avanzados de Blanes, germen del actual IIIA-CSIC, a mediados de los años ochenta. ¿A que se dedicaban entonces?

En aquella etapa se investigaba en campos fundamentales como el desarrollo de lógicas complejas. La informática utilizaba básicamente la lógica binaria, de sí o no. Cuando un programa tomaba una decisión había solamente estas dos opciones. Para abordar algunos problemas esto no funciona bien. Por ejemplo, trabajábamos en el campo de la medicina y para analizar la fiebre de un enfermo es insuficiente saber si un enfermo tiene o no fiebre. Necesitábamos trabajar con graduaciones. No es lo mismo tener poca, que bastante o que mucha fiebre. Las acciones a tomar son distintas. En esos casos, trabajar con una lógica limitada a sí o no puede hacer que una circunstancia muy pequeña, como una fiebre muy baja, desencadene una acción muy fuerte solo recomendada para fiebres altas. De ahí surgieron soluciones como las lógicas difusas, técnicas matemáticas que nos ayudan a tratar estos problemas. A día de hoy, esto puede parecer algo muy básico, pero en aquel momento no existía y fue muy importante.

La IA tiene más de sesenta años, debe de haber encontrado dificultades

Entre otros proyectos, en los inicios se invirtió mucho en los traductores automáticos de ruso a inglés y fue un fracaso. Años después este campo ha evolucionado mucho y ahora funciona bastante bien pero elementos lingüísticos como el sentido del humor, las metáforas o el contexto siguen siendo muy complicados de tratar. Aunque nos gusta atribuir actitudes humanas a las máquinas, en realidad estas no piensan, no entienden nada.

“Nos gusta atribuir actitudes humanas a las máquinas pero en realidad estas no piensan, no entienden nada”

¿Qué es lo que ha llevado a la IA a esta fase de esplendor?

En algunos casos, como las redes neuronales, la base científica se creó hace muchos años pero no existían las máquinas para desarrollarla. El gran aumento en la potencia de cálculo de los dispositivos y la inmensa cantidad de datos generados por los usuarios en internet o almacenados por las empresas es lo que ha hecho resurgir la Inteligencia Artificial.

Una de las barreras para acercarnos a esta especialidad es comprender en qué consiste, ¿podría explicarlo?

Es muy difícil definir la Inteligencia Artificial porque es muy difícil definir la Inteligencia, todas las definiciones son muy vagas y han ido cambiando con el tiempo. Hoy consideramos que la autonomía y la adaptación son características fundamentales de las máquinas basadas en IA. Es decir, un programa no debe depender de un elemento externo para funcionar, debe adaptarse, aprender de las experiencias. Un teléfono móvil, por ejemplo, no puede dejar de funcionar al perder acceso a una red inalámbrica. Debe disponer de alternativas, buscar otra red disponible, poner en espera y retomar más tarde aquellas tareas que necesiten acceso a la red o preguntar al usuario, pero en ningún caso bloquearse. Otro aspecto muy actual es que un dispositivo de IA debe estar situado en su entorno. Los humanos estamos situados e interactuamos con nuestro entorno y los programas también deben percibir aspectos del mundo físico o virtual con el que se relaciona para poder reaccionar adecuadamente ante estímulos o cambios en su estado.

Como, por ejemplo, los robots

Así es, los robots son un buen ejemplo. Presentan de manera muy visible muchas de las características y técnicas de la IA. Intentan ser autónomos, aprender, utilizan sensores y pueden tener visión de su entorno para moverse adecuadamente, escuchar y tener lenguaje para comunicarse, etc…

Precisamente los robots se identifican con la idea de que el objetivo de la IA es imitar al hombre para reemplazarlo

Se trata de ayudar a las personas en tareas en las que una máquina puede ser útil. Se han hecho proyectos de enjambres de robots que podrían entrar a buscar heridos en una situación catastrófica donde es posible que un bombero no pueda entrar o el riesgo sea muy alto. A veces la IA es parte de un sistema más complejo, en medicina para diagnóstico o en robots para guiado de operaciones, por ejemplo. Son sistemas de ayuda que necesitan ser controlados por un humano, porque sustituirlo es demasiado complicado y desde un punto de vista ético no se puede dejar el control a una máquina. En algunas tareas sería deseable que las máquinas nos sustituyan pero si la gente que las realiza pierde su medio de vida, será un problema puramente social que debe ser abordado por la política.

¿Cómo se hace la Inteligencia Artificial? ¿A qué se dedican ustedes?

Es muy amplio y hay muchos trabajos distintos. Por un lado algunos investigadores hacen una investigación fundamental, muy matemática, con teoremas, algoritmos o definiendo nuevas lógicas que nos ayudan a abordar problemas cada vez más complejos y de maneras más eficientes. En muchos casos es un trabajo a largo plazo y con gran incertidumbre. Por otro lado, está la aplicación de los algoritmos y las técnicas de la IA a problemas concretos, que requiere un conocimiento experto de esta tecnología pero también entender el campo de aplicación. Esto exige un trabajo conjunto con especialistas de otras disciplinas, médicos, ingenieros, filósofos, astrofísicos o psicólogos.

¿Podría explicarnos cómo es esa colaboración?

Por ejemplo, la Inteligencia Emocional Artificial funciona con una base de emociones. Se puede utilizar en un programa que identifique las distintas emociones positivas o negativas sobre un tema analizando el lenguaje natural de usuarios en una red social. También se pueden programar respuestas asociadas a una determinada emoción. Para ello es necesario colaborar con psicólogos. Son ellos los que conocen y entienden las emociones.

Para imitar la inteligencia deben ustedes analizarla primero

Se valora poco, pero la investigación en IA nos obliga a pensar y entender nuestra propia inteligencia, es muy interesante.

“La investigación de la Inteligencia Artificial nos obliga a pensar y entender nuestra propia inteligencia”

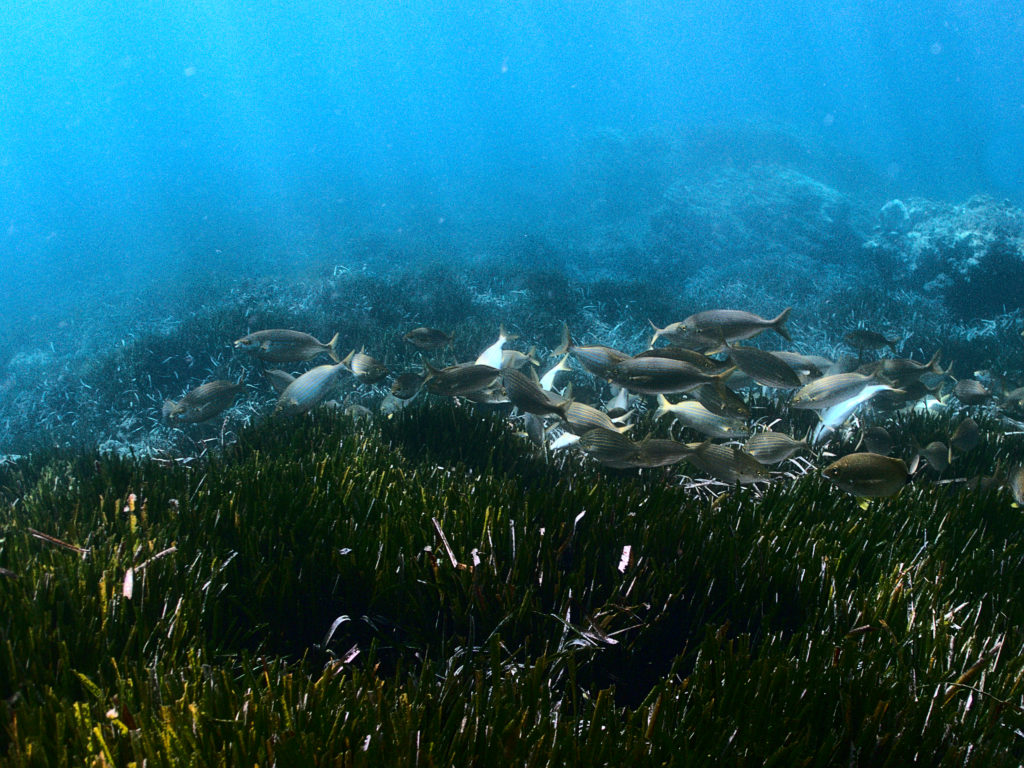

Algunas de las líneas de trabajo de la Inteligencia Artificial como la Inteligencia de Enjambre parece relacionada con animales

Desde el punto de vista de una entidad, un humano es muy complejo y tratamos de emular esa inteligencia. Otras especies, como las abejas o las hormigas, son mucho más simples a nivel individual pero tienen un comportamiento social muy complejo. Los biólogos habían estudiado mucho estas conductas. El investigador de IA Marco Dorigo en los años noventa ya comenzó a buscar aplicaciones tomando el comportamiento de las colonias de hormigas cuando buscan alimentos. Cuando salen a por comida, las hormigas se distribuyen aleatoriamente en todas direcciones y dejan un rastro de feromonas que otras hormigas tienden a seguir. Aquellas hormigas que encuentran comida más cerca vuelven antes y por tanto aumenta el rastro de feromonas de ese camino que es seguido por más hormigas que lo reforzarán aún más. Poco después, todas las hormigas estarán siguiendo el camino más corto hacia la comida. Es un mecanismo de inteligencia social que poco tiene que ver con la inteligencia individual pero que ha sido imitado para crear técnicas que se utilizan, por ejemplo, en redes de telecomunicaciones y que se siguen mejorando.

Los aspectos éticos de la IA están siendo discutidos al más alto nivel en organizaciones como la Comisión Europea o la UNESCO, ¿son tan importantes?

Es un tema imprescindible porque la IA ha entrado en nuestra vida y es necesario establecer principios que no tienen que ver con la ciencia ni con la tecnología, son cuestiones a regular políticamente. En el caso del coche autónomo, por ejemplo, puede ser la mayor limitación para su aplicación real. Hay que establecer la cadena de responsabilidad, ¿quién es responsable en caso de accidente?, ¿el propietario?, ¿el fabricante?, ¿los ingenieros?. Un fabricante ¿tiene derecho moral para hacer que un coche proteja siempre a su propietario?, ¿incluso si para ello es necesario atropellar a un grupo de niños?, ¿se debe permitir?.

Los sesgos por sexo, raza, edad, etc. en algoritmos empleados por empresas o instituciones para recomendarnos productos, seleccionar candidatos a empleos o responder preguntas, entre otras muchas cuestiones, también son un reto ético, ¿son inevitables?

Por un lado una máquina de IA aprende de ejemplos, de muchos casos reales que tienen esos sesgos y por tanto presentará los mismos problemas. Es como llevar a un niño con malas compañías, aprende a ser malo. El gran problema es la falta de transparencia. Todos estos algoritmos, como el deep learning son una caja negra. Cuando aprenden, elaboran un modelo matemático implícito donde los humanos intervienen muy poco o nada. Por ejemplo, un algoritmo de IA para evaluar a clientes de un banco que solicitan un crédito puede dar una respuesta sobre si un cliente es más o menos apto pero no puede decirnos por qué, si es por sus ingresos, hábitos de compra, edad, sexo o qué combinación de todos esos factores. Existe toda una línea de investigación para hacer estos algoritmos explicables y que las personas podamos entender por qué han tomado una decisión.

”Un algoritmo puede dar una respuesta sobre si un cliente es más o menos apto para un crédito pero no puede decirnos por qué”

Usted co-dirige la Unidad de Desarrollo tecnológico en Inteligencia Artificial (UDT-IA) que tiene por objetivo la transferencia de conocimiento del IIIA-CSIC a la sociedad, ¿como realizan esta transferencia?

Hablando con mucha gente. Realizamos jornadas tecnológicas, analizamos sus problemas y proponemos soluciones. Hay un equipo de ingenieros con un perfil mixto entre el ámbito más científico y el empresarial. Ellos son capaces de entender las necesidades reales y cómo estas tecnologías pueden ayudarles. Por otro lado, han surgido del IIIA varias empresas spin-off que aplican la IA en áreas como las recomendaciones en el sector financiero y el de los asistentes digitales que interaccionan con clientes o empleados.

¿Cómo ve el futuro de la Inteligencia Artificial?

En los últimos años se ha progresado muchísimo, quizás no tanto como algunos dicen, pero aún así el potencial es enorme. Es muy transversal, se puede utilizar para muchas cosas distintas, visión por computador que identifica objetos, dictado automático que reconoce la voz, análisis de diferentes tipos de datos, etc. Las empresas se están dando cuenta y muestran mucho interés en absorberla para sus producciones.

Si te ha gustado esta entrevista y quieres aprender más sobre IA haz click aquí