La Biblioteca Virtual Miguel de Cervantes abre un portal dedicado al Sanatorio de Fontilles para preservar la memoria de la lepra en España

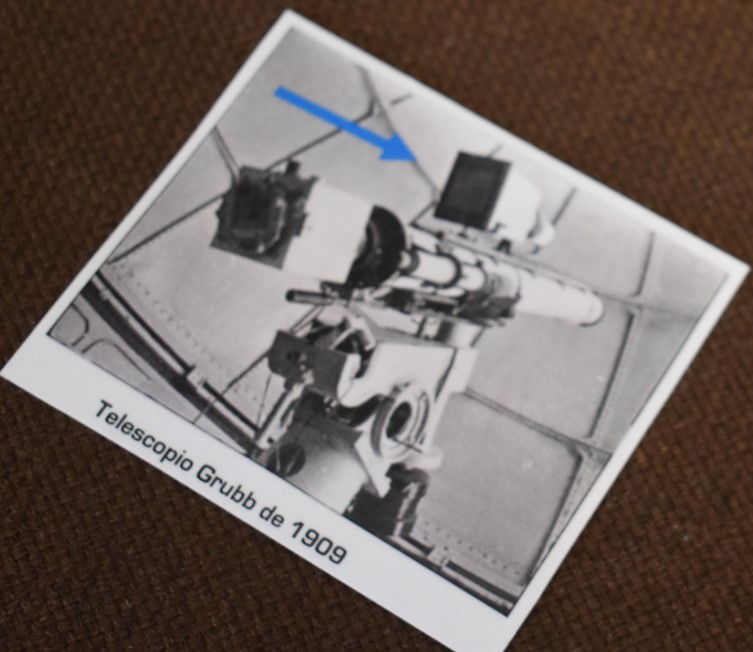

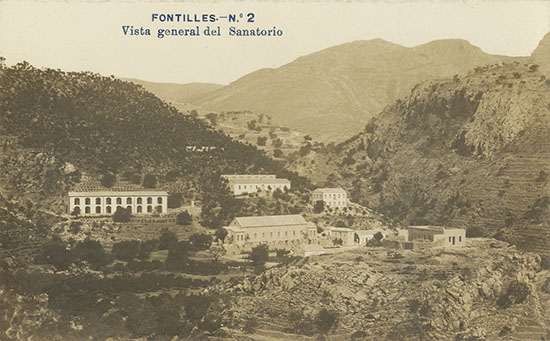

La Colonia-Sanatorio de Fontilles (Vall de Laguar, Alicante) abrió sus puertas en 1909 a un grupo de ocho afectados de lepra para su cuidado. Hoy, 110 años después, abre sus puertas al mundo digital a través de una plataforma desde la que aproximarse a su historia por medio de imágenes, fotografías, publicaciones e historias de vida de quienes padecieron esta enfermedad. El proyecto, dirigido por el profesor de la Universidad de Alicante, Antonio García Belmar y coordinado por Eduardo de Miguel, de la Fundación Fontilles; pretende preservar la memoria de una experiencia colectiva con el objetivo de dignificar la enfermedad y a quienes la sufrieron.

La lepra es una enfermedad causada por un bacilo, Mycobacterium leprae, que se multiplica muy despacio, ralentizando la aparición de los síntomas, en ocasiones, hasta veinte años después. La enfermedad afecta principalmente a la piel, los nervios periféricos, la mucosa de las vías respiratorias superiores y los ojos. Es una enfermedad que puede curarse con un tratamiento multimedicamentoso pero si no se trata puede causar lesiones permanentes graves.

Actualmente su incidencia en España es bastante baja, en comparación con la situación que se vive en otros países como Etiopía, Brasil o India. Apenas once casos se registraron en nuestro país el pasado año 2018. De estos casos, tres afectados eran de nacionalidad española y el resto, de nacionalidad extranjera, ya infectados, que viajaron a España donde fueron diagnosticados y tratados, según explica Eduardo de Miguel, coordinador de proyectos internacionales de Fontilles.

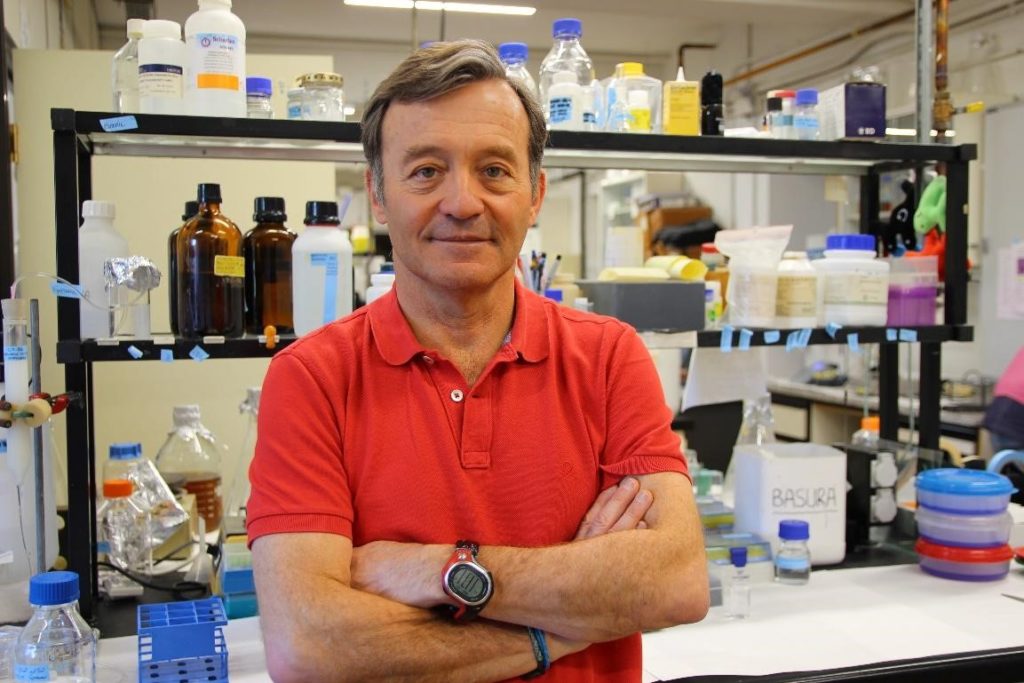

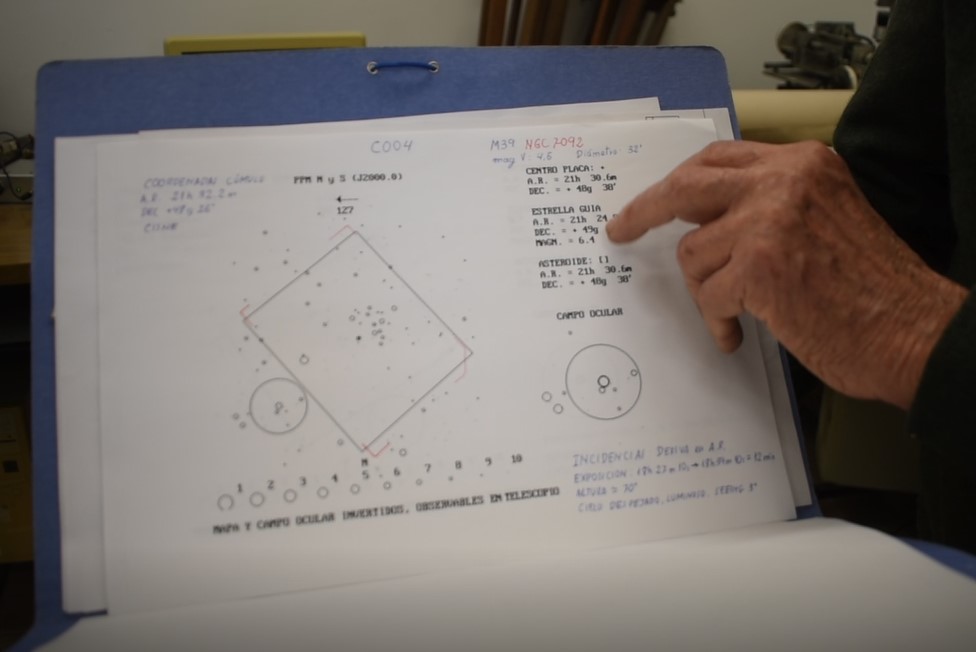

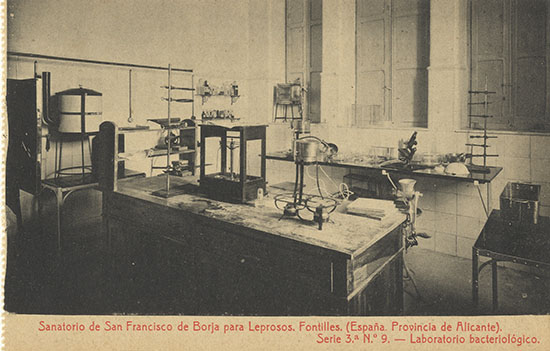

El primer laboratorio, instalado en el edificio de la clínica en 1924 / Biblioteca Virtual Miguel de Cervantes

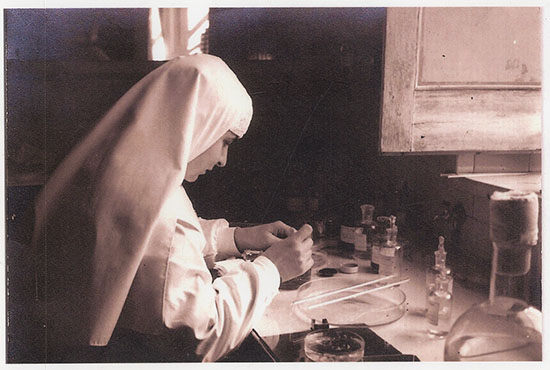

La madre Teresa Biosca prepara las muestras en el laboratorio de la clínica 1924 / Biblioteca Virtual Miguel de Cervantes

Casi todo en la lepra son datos, mediciones, índices y cuantía de afectados. Sin identidades, sin nombres propios. Enfermos que siempre se sintieron aislados por una sociedad que temía, y aún sigue temiendo, lo desconocido. A los pocos años de la apertura de Fontilles, un muro de más de tres kilómetros de largo se encargó de delimitar claramente la colonia-sanatorio del resto del pueblo. La reclusión y la segregación han estado siempre presentes en la historia de este lugar que se convirtió en un pueblo para aquellos que no tuvieron más remedio que recluirse allí esperando poder ser curados.

Más de tres mil almas han pasado parte de su vida entre las paredes de aquel complejo sanitario. Un lugar que, durante los años ochenta, apostó por la rehabilitación integral de las personas enfermas, tanto a nivel físico, como psicológico, social y laboral. De muy pocos de ellos se conocen sus historias, sus narraciones sobre toda una vida marcada por esta enfermedad y ese ha sido, en parte, uno de los objetivos de trabajo: la recuperación de las historias de vida de algunos afectados.

La lepra y sus metáforas

Marginación, miedo, mito y estigma son palabras que van unidas al nombre de una enfermedad: lepra. Una afección siempre rodeada por un halo de desconocimiento y metáforas de la enfermedad, que ejercieron una función social de control y que solían acentuar los aspectos más repelentes de la misma. Se creó una imagen social de la lepra que posaba el acento en el aislamiento y la estigmatización que vivieron los enfermos que se recogían en sanatorios para su tratamiento médico, como fue el caso de la colonia de Fontilles. Todos ellos son conceptos que han de ponerse en evidencia, criticarse y desgastar, para que dejen de asociarse a la lepra. Y en esa labor de desgaste es, en parte, uno de los objetivos del proyecto Fontilles que se aloja en la Biblioteca Virtual Miguel de Cervantes desde hace solo unas semanas.

Historia de un proyecto

García Belmar comenta que la colaboración entre la Universidad de Alicante y la Fundación Fontilles viene de años atrás. Los primeros trabajos que hay, abordados desde la historia de la ciencia, relacionados con Fontilles, son los de Josep Bernabéu, de la Universidad de Alicante, sobre el conjunto, la revista, el surgimiento del sanatorio y su contexto en la España de principios del siglo XX, así como sobre las metáforas de la enfermedad.

Tal y como describe García Belmar, la Fundación Fontilles entró en contacto con la universidad hace unos seis años, para plantear la posibilidad de crear un proyecto museográfico con los fondos históricos del sanatorio para la difusión y preservación de los documentos: “Aquel proyecto quedó en un segundo plano y más adelante volvimos a entrar en contacto con Eduardo de Miguel para elaborar otro para la petición de una subvención a la Sasakawa Memorial Health Foundation”. Ese proyecto era de recuperación y preservación de patrimonio histórico al que se añadía algo que, hasta ahora, no se había tenido en cuenta de manera sistemática, que eran las fuentes orales: testimonios y experiencias de vida de personas que habían padecido la enfermedad. La incorporación de todas estas propuestas hizo que la fundación japonesa se interesara por él y lo financiara. Su papel ha sido fundamental al poner los fondos, pero también ha orientado y dado fuerza a este proyecto, según cuenta Antonio García Belmar.

El proyecto siempre se ha considerado importante, pero había quedado en un segundo plano en otras ocasiones por problemas de financiación. Existen algunos aspectos urgentes como son la conservación del material, que corre el riesgo del deterioro, y también la parte de los testimonios orales. Contra todo ello el tiempo es el elemento apremiante. Como explica Eduardo de Miguel: “Nuestros residentes en Fontilles son personas de avanzada edad y por lógica de la vida existía una cierta urgencia en poder recoger esos testimonios para la posteridad”.

Cuando se presentó la propuesta a la Biblioteca Virtual Miguel de Cervantes, la respuesta y la acogida fueron muy positivas y generosas y así se ha convertido en un espacio donde alojar todos esos materiales digitalizados con una visibilidad y una difusión que por otros medios no hubiera sido posible conseguir- comenta Antonio García Belmar.

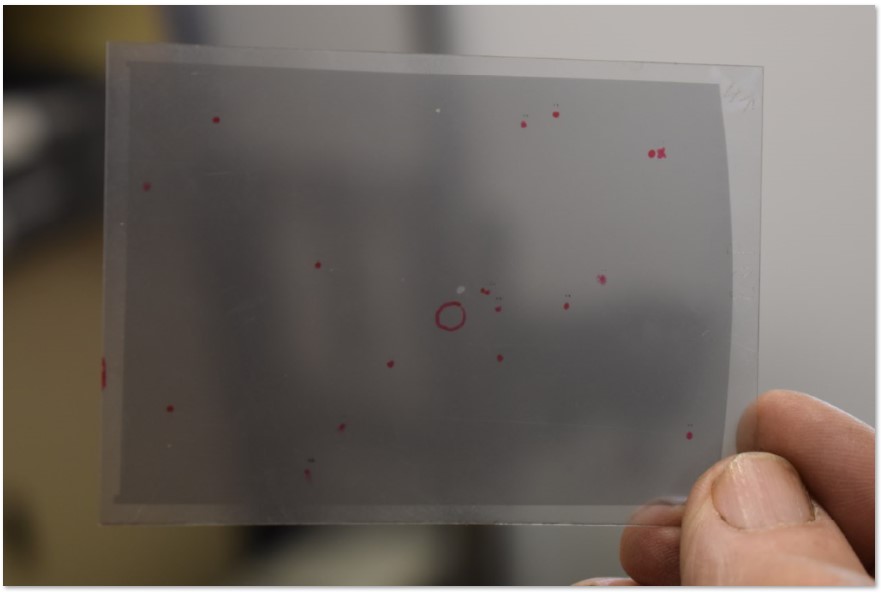

Bajo el título Fontilles y la lepra en España, se encuentra una amplia muestra de revistas, obras, imágenes, testimonios, documentos y objetos del patrimonio histórico del sanatorio, además de un catálogo bibliográfico con las obras conservadas en la Biblioteca Médica de Fontilles; así como las dos revistas publicadas por el sanatorio que fueron, y son, un importante canal de difusión de las investigaciones sobre la lepra.

A todo ello hay que sumarle un banco de unas quinientas imágenes, seleccionadas del Archivo Fotográfico, elegidas por su calidad técnica y artística. Por último, mapas y gráficos, planos y proyectos arquitectónicos de los edificios del centro.

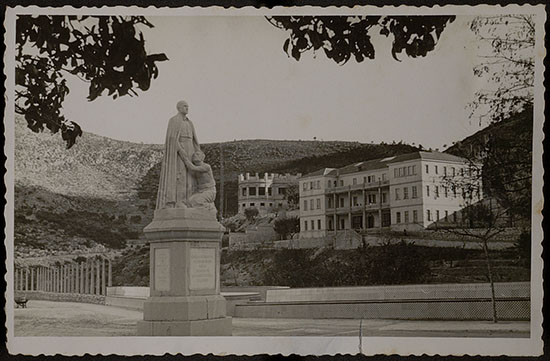

Residencia de mujeres en 1933 / Biblioteca Virtual Miguel de Cervantes

Reunión en el patio central del pabellón de Santa Isabel en 1949 / Biblioteca Virtual Miguel de Cervantes

Recuperar la memoria de los afectados

Pero este proyecto va mucho más allá de la simple conservación y exhibición de años de historia a través de lo material. Este proyecto destaca la importancia y el valor de la preservación de la memoria de las enfermedades y de quienes la padecieron. Y es que, todos los especialistas coinciden, tan importante y necesaria es la educación sanitaria como la educación social, para lograr eliminar el estigma que siempre ha acompañado a la lepra.

“Es la gran batalla”, dice apesarado Antonio García. A juicio del director, la batalla médica, gracias a que existe un tratamiento efectivo y estandarizado, está ganada. Aunque el tratamiento no sea igualitario en países como Brasil o India donde es una enfermedad todavía muy complicada. A pesar de todo, un elemento fundamental que sigue provocando daños, es el estigma. Este hace que la enfermedad se oculte, tanto por parte de quienes la padecen, como por parte de los gobiernos y así lo único que se consigue es alimentarla cada vez más, que avance, progrese y siga haciendo daño. “La lucha contra el estigma es un objetivo de este proyecto”, aclara García Belmar.

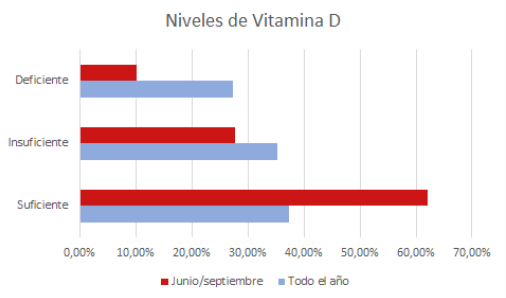

Eduardo de Miguel, conocedor de la situación de la enfermedad en otros países, comenta que las actividades de sensibilización que se realizan en Fontilles están vinculadas, principalmente, a dos aspectos: lepra y pobreza y lepra y mujeres. Se hace hincapié en las causas del padecimiento de la enfermedad y su relación con la población más pobre. Se trata de campañas que explican cómo la enfermedad afecta, especialmente, al colectivo de las mujeres en países donde tienen mayores dificultades para acceder a los recursos sanitarios y la lepra les afecta en mayor medida.

Todavía viven algunos afectados en Fontilles, en concreto veintidós, mejor dicho, ex afectados, como puntualiza Eduardo de Miguel: “Los que aquí viven algún día padecieron la enfermedad, aunque ahora ya no y lo que queda de ella son solo las secuelas. Son personas de avanzada edad que están aquí, no porque estén recibiendo ningún tratamiento, ni estén ingresados, sino que para ellos Fontilles es su casa y han decidido vivir aquí el resto de los días que le quedan.”

Desde el mes de junio de 2016, se han realizado entrevistas a las personas que todavía residen en el Sanatorio de Fontilles y que aceptaron compartir el testimonio de sus vidas. Las dieciocho historias de vida registradas en casi sesenta horas de grabación y transcritas en un documento de varios cientos de páginas han sido analizadas, organizadas temáticamente y preparadas para su publicación en forma de libro. Es muy poco lo que se sabe de las personas que padecieron esta enfermedad que les marcó para siempre tanto física como emocionalmente. El principio parecía sencillo, dice García Belmar, bastaba con preguntar, sí, pero también había que estar dispuestos a aceptar las respuestas de unas historias de vida que están desapareciendo y para las cuales el tiempo juega en su contra.

Resulta esencial prestar atención a estos testimonios, a los sentimientos que de ellos se desprenden. El sonido de estas palabras, su entonación, sus silencios y pausas, absolutamente todo contribuye a comprender qué significó ser un enfermo de lepra entre las paredes de este antiguo sanatorio. Con este proyecto se recupera la oportunidad de recoger y conservar esta parte esencial del patrimonio histórico de Fontilles y de la historia de la lepra en España: el testimonio de quienes se enfrentaron a ella.

Cuando ya has escuchado los testimonios, no solo estos de Fontilles, de personas afectadas por la lepra, en momentos de la historia diferentes o en contexto sociales, económicos y sociales diferentes, al final todos repiten un mismo patrón. Un patrón que está relacionado con su exclusión y con el estigma y se repite en diferentes puntos de planeta. Un aspecto curioso desde el punto de vista de lo particular que es esta enfermedad. – E.M.

Una práctica de los años ochenta

Los primeros estudios realizados con fuentes orales, en España, en el siglo XX, fueron desarrollados a partir de testimonios obtenidos de supervivientes de la guerra civil. Pero el primer archivo de Historia Oral surgió en 1983, el Arxiu Històric de la Ciutat de Barcelona, con el objetivo de diseñar y elaborar proyectos interdisciplinarios de investigación; captar y conservar documentación y testimonios personales; proceder al tratamiento archivístico de las fuentes para facilitar su consulta y publicar el material documental relacionado con la información obtenida. Otras iniciativas han trabajado en la recuperación de la memoria colectiva de la Segunda República, la Guerra Civil, el Franquismo y la Transición. Desde el punto de vista internacional, el establecimiento como asociación en 1996 de la International Oral History Association (IOHA), ha significado la posibilidad de crear una red de colaboración y de transmisión de conocimientos trascendental para el desarrollo de la Historia Oral. En la actualidad, y gracias a la definición de herencia cultural intangible, realizada por la UNESCO, la tendencia es constituir centros globales que no solo realicen la labor de recuperación y conservación de los testimonios orales, sino que posibiliten la utilización y exhibición de estos.

La historia oral es un elemento esencial para comprender la historia de esta enfermedad. Es una deuda con esas personas que se han mantenido en silencio durante mucho tiempo. Antes de empezar las entrevistas siempre hay una explicación previa a aquellos que quieren participar y ellos finalmente deciden si quieren hacerlo y por qué. En la mayoría de los casos lo que pretenden en dar a conocer su realidad.

Como aclara el director del proyecto, estos testimonios tienen un doble valor y es que, además, aportan información como no lo hacen otras fuentes. Son capaces de descubrir aspectos de la realidad de la enfermedad que las fuentes gráficas o escritas no dan. Hay otra información en ellas que es la percepción particular de la enfermedad, el significado de esta, la explicación que cada enfermo le otorga a su padecimiento. Esa es una información muy valiosa porque incluso ayuda a comprender las consecuencias que tiene estigmatizar a un colectivo por las razones que sea.

Se pretende que el proyecto de historia oral acabe en la publicación de un libro con las transcripciones de las entrevistas que completen los fragmentos de la fonoteca por una razón de peso que explica García Belmar: “Nunca es igual la lectura de los testimonios que la escucha de los mismos. Toda la información contenida en las palabras, la cadencia, el acento, las emociones… todo eso se pierde en la transcripción y por eso creemos que deben complementarse”.

Pensamos que estos testimonios y su salvaguarda podían ser útiles en el futuro para luchar contra la exclusión social y discriminación que sufren otros colectivos. Creemos que esa es la utilidad que puede tener este trabajo para la humanidad, independientemente del valor que pueda tener para investigadores o especialistas que estén interesados en el tema. – E.M.

Visibilizar y sensibilizar como objetivos fundamentales

La lepra es una enfermedad que ha afectado mucho a aquellos que la padecieron y una de las principales contribuciones de este proyecto es ayudar a recuperar la dignidad de la memoria de aquellos que todavía no pueden expresar abiertamente que la sufrieron y ahora están curados.

Ellos lo dicen, realmente la enfermedad era curable y podía hacerse rápido y sin secuelas, ahora bien, el problema es que una vez que fueron diagnosticados, uno es leproso para toda la vida. Esa es la auténtica batalla, no tanto la lucha contra la bacteria causante, sino contra el estigma que ha condicionado toda su vida. – G.B.

El desconocimiento de la enfermedad en la actualidad continúa siendo unos de los caballos de batalla del día a día de especialistas y fundaciones como la de Fontilles. Hay que explicar constantemente que la lepra no tiene la imagen que a la gente suele traerle al subconsciente, de personas con rostros desfigurados, con muchas lesiones a nivel externo. Hay otras formas de manifestarse, que no son tan violentas ni tan visibles, aunque también acaban generando estigma. Lo cuenta quien trabaja de primera mano con una enfermedad con desigual incidencia en el mundo: “La gente piensa que ya no existe, que es una enfermedad del pasado y sin embargo no es cierto. Incidimos sobre este tema de manera especial el Día Mundial de la Lucha contra la Lepra, que es el último domingo de enero, pero en realidad es parte de nuestro trabajo diario”- comenta Eduardo de Miguel.

La gente que se aproxima a Fontilles lo hace desde muy diversos puntos de vista, a veces social, otras histórico, antropológico o incluso arquitectónico. Uno de los fines de este proyecto es que todas esas visiones se vayan entrelazando para lo que es el fin último: la lucha contra la enfermedad, la lucha contra la exclusión social y la defensa de los derechos humanos. Todo está unido y tan importante es para la Fundación la conservación y puesta en valor de los documentos y los testimonios a corto plazo, como la defensa de los colectivos que en el siglo XXI siguen padeciendo la exclusión social por enfermedad. Ciertamente esta plataforma ha de contribuir a visibilizar y sensibilizar sobre esta enfermedad entre la sociedad. Así lo afirman, esperanzados, los responsables del proyecto.

Tras la catalogación, el archivo y la digitalización de todos los documentos, el objetivo es llevar a cabo una difusión del proyecto por medio de varias iniciativas. Una de ellas es la presentación en congresos o reuniones científicas o incluso elaborar alguna publicación. Pero, además, el objetivo es ofrecer la experiencia a otros espacios similares a Fontilles, que cuenten con fondos de archivo, biblioteca, fondos fotográficos y fondos gráficos. Algo así como un asesoramiento para la recuperación de su patrimonio.

Antonio García Belmar comenta que ya hay programado un encuentro con personas que trabajan en entidades similares en Grecia y Portugal y también en Noruega e Italia. El objetivo es crear una especie de consorcio, intercambiar experiencias y llevar este modelo de trabajo a otros lugares donde pueda aplicarse.

Eduardo de Miguel aclara que este no es un proyecto que aparece de manera aislada, sino que surge en un contexto, de trabajo global, en el que otras instituciones a nivel europeo y mundial están intentando rescatar del olvido y de la destrucción todo ese patrimonio material e inmaterial, a través de los testimonios de los enfermos. Europa, Asia y América Latina, principalmente, están creando unas conexiones que están generando un proyecto vivo y dinámico. El fin es que todo aquello que sea posible preservar y conservar, que esté vinculado con antiguas leproserías, quede a disposición de la humanidad, en general, para lo que pueda ser útil. “Yo quiero pensar que esto empieza aquí y que va a ir generando un tipo de redes de antiguas leproserías que en un futuro puedan acabar incrementando ese patrimonio digital a través de la Miguel de Cervantes, o desde otra plataforma”,comenta con entusiasmo De Miguel.

Después de cuatro años de trabajo,de los cuales dos de ellos han contado con la financiación de la Sasakawa Memorial Health Foundation, se ha logrado la formación de una plataforma a la que es interesante asomarse, para conocer más sobre una enfermedad, a la que el conocimiento científico y médico, ha hecho menos dolorosa y peligrosa. Sin embargo, el conocimiento social e histórico aún no ha conseguido mermar las falsas creencias y mitos que sobre ella perduran hoy en día. Quiera que proyectos como este lo consigan y palabras como las de Salvador Sellés, plasmadas en un poema en 1912 que lleva por título Lepra, no se repitan:

¡Oh la lepra invisible y demoníaca!

Ella acecha y ataca: nos envuelve en sus redes y sus lazos, nos invade ganando vena a vena, nuestra sangre envenena y desprende los miembros a pedazos.